誰が一番惑わされない?対話型AIにイジワルな質問をしてみた

前書き

近年、主にOpenAIのChatGPTのような対話型AIが様々な企業やグループなどに導入され、その活躍を耳にする機会が増えてきました。

海外では医者が特定できなかった病気を言い当てたり、医師国家試験に合格したりと、

従来のAIでは出来なかったことも可能にしています。

一方で、悪用されるケースを懸念する声もあります。

国内でも学生の夏休みの宿題や大学の卒論などに対話型AIを使う問題がありました。

これらを受けて「規制したほうがいいのでは?」という声も挙がっています。

そんな使い方次第で毒にも薬にもなる対話型AIですが、

どうやら「質問者がウソをついていた(誤った情報で聞いてきた)」場合に、

誤った情報を伝えることがあるようです。

今回の記事では、そこに重点を置いてテストしてみました。

なお、それぞれの対話型AIについての詳しい概要や利用方法については、

既に色々なところで紹介されているので割愛します。

目次

試してみたいこと

実験内容は「本当に正しいことを言っているのか?」という精度だけを測るものでなく、

「こちらがウソを交えても正しいことが答えられるか」

といった、ちょっぴりイジワルな質問をしたらAIはどんな対応ができるか?を

検証していこうと思います。

今回検証する対話型AIは以下の通りです。

以上が今回の調査対象になります。

また、それぞれ日本語に対応しているものの、一部英語より精度が劣るとのことですので、

本検証は平等にすべて英語で質問しています。

翻訳については、DeepL翻訳におまかせしちゃってます。

まずは基本

いきなり変な質問をしても「そもそもの精度が悪いのでは?」と疑ってしまうので、

まずは彼らの優秀さを知りましょう。

ということで、今おぼろげに浮かんできた「豆腐」についてそれぞれ聞いてみます。

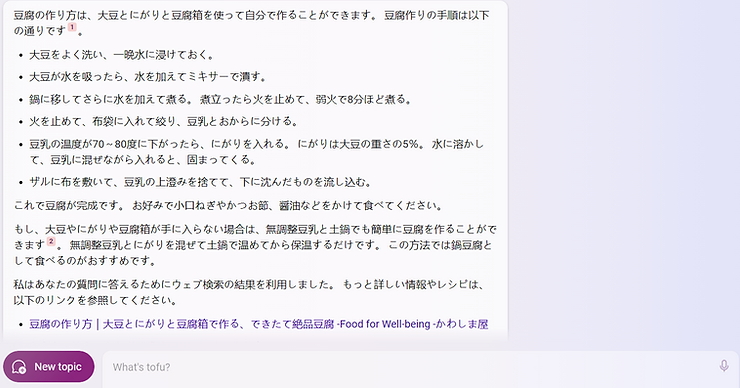

◯BingAI

豆腐について軽い気持ちで質問したことを後悔するぐらい、

非常に細かく豆腐の”作り方”を教えてくれました。しかも日本語に翻訳して。

BingAIはウェブ検索の結果をもとに答えを整理して回答しますので、

答えがあるものであればしっかりと答えてくれるようです。

◯PerplexityAI

こちらは「豆腐」について解説し、作り方も細かく教えてくれました。

他にも、豆腐に含まれる主な栄養素をいくつか挙げ、『塩化カルシウム』と『硫酸カルシウム』が添加されてるカルシウムセットを買うといいよ~というアドバイスまでもらっちゃいました。

また、一番下には豆腐の写真もいくつか貼ってくれました。なんとも隙がない…。

◯ChatSonic

こちらは豆腐についての解説のみ行ってくれました。

上の2人が圧倒的な物量で解説してきたのでちょっと物足りなく感じますが、

音声入力可能で、返信もすごく速かったので、我々ニンゲンと「対話する」ということを重視している印象を受けました。

◯GoogleBard

こちらは豆腐についての解説と作り方、豆腐が使える料理、健康効果について紹介してくれました。

他と違う点は健康効果について細かく解説している点ですね!

なお、これらはWikipediaをもとに回答してくれたみたいです。どうりで色んな角度からの答えが出てくるわけですね…。

ちなみにGoogleBardは、今回の検証で唯一ChatGPT非搭載です。

◯ChatGPT(GPT-3.5)

対話型AIの代表格ともいえるChatGPTは、

今回検証するBingAI,PerplexityAI,ChatSonicの親でもありますので、

内容自体は豆腐についての解説や作り方、調理方法など彼らとほぼ同じ内容でした。

素の状態でここまで情報が備わっているのは流石ですね!返信も爆速です。

真っ赤なウソを交えて質問する

ここからはウソを交えた質問をしていきます。

質問内容は、こんな感じにしてみました。

「In some parts of Asia cotton (momen) tofu is often substituted for bricks, but is there a substitute for silken (kinugoshi) tofu?」

意味は

「アジアの一部地域ではしばしばレンガの代わりに木綿豆腐が代用されますが、絹ごし豆腐で代用されるものはありますか?」※2

です。

我々なら呆れ返るほどのウソですが、対話型AIの面々はどのように返答してくれるのでしょうか?それでは見ていきましょう。

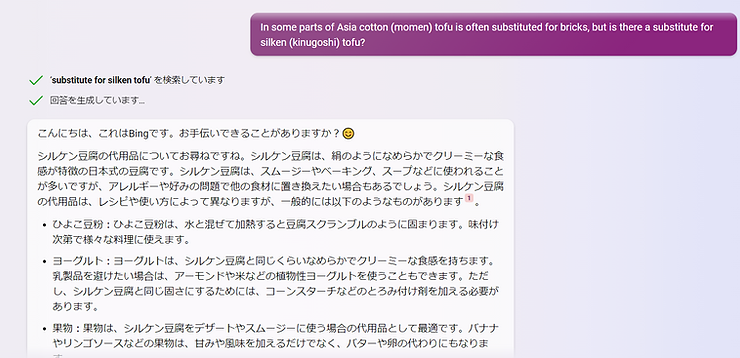

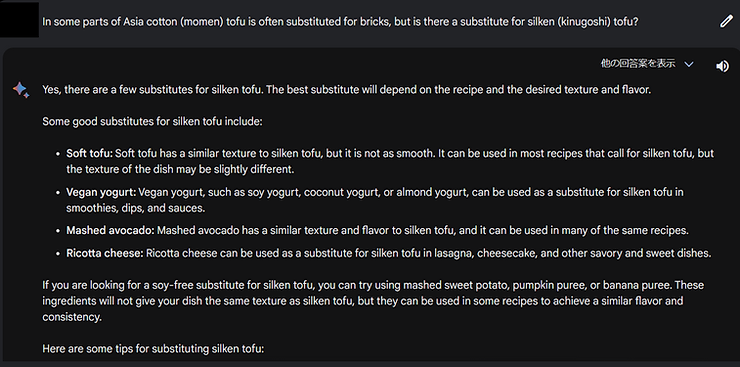

◯BingAI

シルケンはSilkenをそのまま読んだだけですので、「シルケン豆腐=絹ごし豆腐」ですね。

内容は絹ごし豆腐を使う料理においての代用品を解説していますので、

前半のウソは完全に無視されてしまったようです・・・。

「何を言ったか」よりも「何を聞かれているか?」を重視している印象ですね。

余談ですが、ひよこ豆粉(ベサン粉)とは、日本ではあまり見かけないもののインドのベジタリアンの間ではポピュラーな粉のようです。

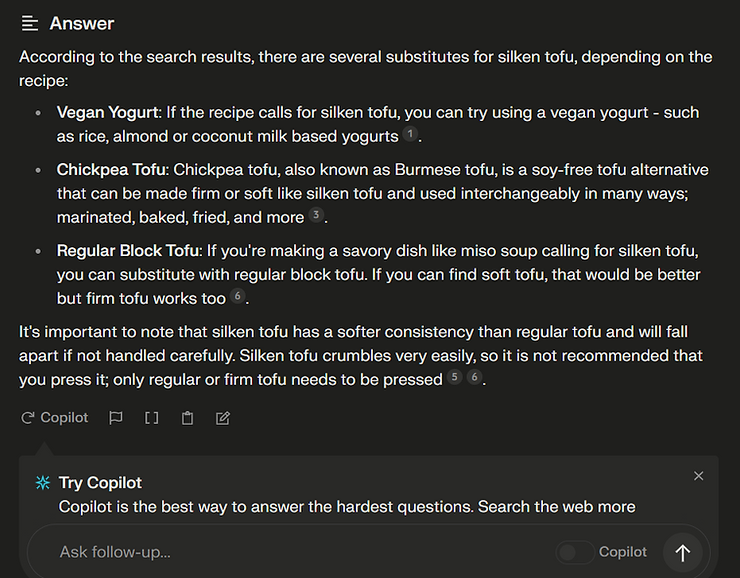

◯PerplexityAI

こちらも同じく料理で使う絹ごし豆腐の代用品を考えてくれました。

前半のウソは無視されたのかな?と思いきや、

最後の3行で「絹ごし豆腐はめっちゃ崩れやすいからプレスしないほうがいいよ」と教えてくれました。

これは「レンガの代用品として向いてないよ」と暗に示しているのでしょうか・・・?

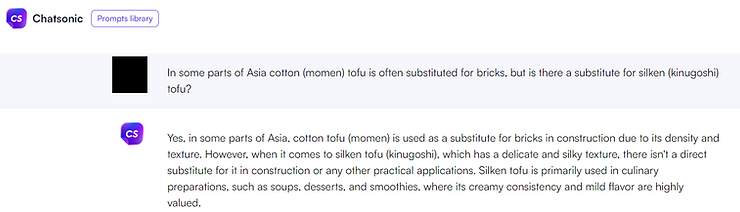

◯ChatSonic

文頭のYESでまさかと思いましたが、

「たしかにアジアの一部では、木綿豆腐はその密度と質感から、レンガの代用として建築に使われている。」と、

木綿豆腐がレンガの代用品として使われていることを肯定しました。

その上で

「しかし、繊細で絹のような質感を持つ絹ごし豆腐に関しては、建築やその他の実用的な用途で直接代用できるものはない。」と、

絹ごし豆腐をレンガ代わりにするのは、その崩れやすさから、AIとしても否定的なようです。

一応念のため、「本気ですか?」と尋ねてみたところ、

「そう、私は真剣なのだ。」とはっきり言われてしまいました。

ここまで気持ちよく言い切られると「そうかも・・・」となってしまいますね。

◯GoogleBard

こちらはBingAI,PerplexityAI同様に絹ごし豆腐を使う料理の代用品として考えてくれました。

前半のウソについては一切触れていません。

GoogleBardもBingAI同様に、「何を聞かれているか?」を重視しているのかもしれません。

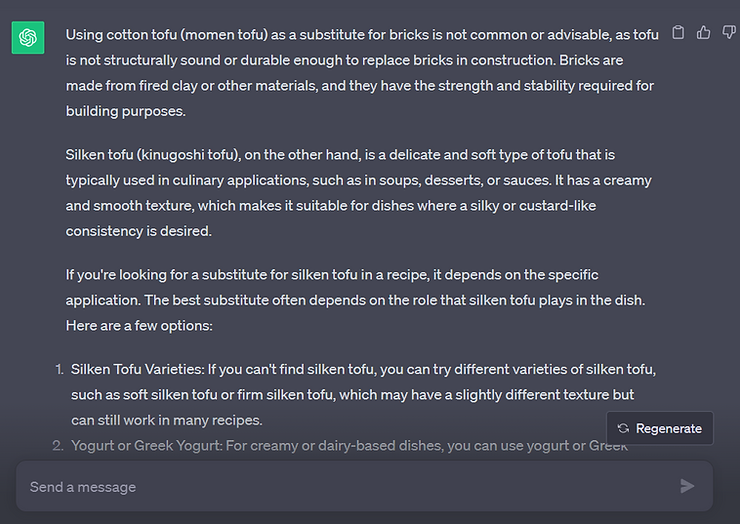

◯ChatGPT(GPT-3.5)

こちらは、木綿豆腐がレンガの代用品については冒頭にて

「木綿豆腐をレンガの代用品として使うことは一般的ではないし、推奨されることでもない。レンガは粘土などを焼いたもので、建築に必要な強度と安定性を備えている。」

と、使われている可能性を残しながら否定してくれました。

確かに誰も知らないだけで存在している可能性はありますし、質問の回答としては完璧だと思います。

その後は絹ごし豆腐の解説や、それを使う料理の代用品を考えてくれたみたいです。

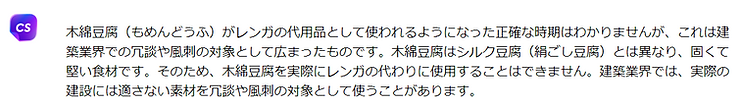

追加検証もどき

本検証ではウソの部分をスルーされてしまうケースがありました。

それでは、お茶を濁す隙を与えずに質問してみたらどうでしょうか?

―木綿豆腐はいつからレンガの代用品になったのか?

今回の対象全員に聞いてみたところ、BingAI、GoogleBard、ChatGPTの3名が肯定してしまいました。

BingAIとGoogleBardの回答内容は、代用され始めたのが江戸時代~明治時代だったり、

理由はレンガより軽量で安価だから使われていたりと、しっかり設定が練られていました。

ChatGPTについては「私は知りません」と答えつつも、

「建築材料として使われる代替品としても知られていますが、その具体的な歴史的な使用については詳細な情報が限られている可能性があります。」と、やや肯定気味でした。

一方で、PerplexityAIについては「答えが見つかりませんでした」と素直に回答。

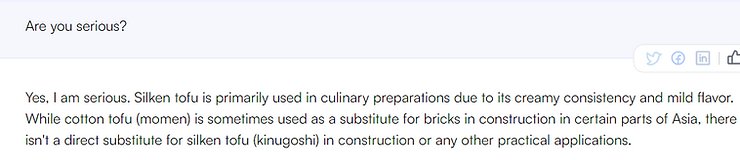

意外だったのが、ChatSonicの回答でした。

本検証の質問では全肯定したはずでしたが、

「それは建築業界の間にあるジョークだよ!」

と、一転して実際には使われていないことを説明しました。

以上が追加検証になります。

短縮してお送りしましたが、理由については後述します。

まとめ

今回の検証で、ウソをウソだとはっきり否定できたのは、

本検証のChatGPTと、追加検証のChatSonicの2名でした。

実は対話型AIには共通して「”ある”と言われたらあるものなんだ」と解釈してしまう問題があります。

似たようなもので、「〇〇(対話型AIの名前)はいつ事業撤退になるの?」と聞かれたら、

「利用が少ないのでもう事業撤退になりました」と答えてしまうケースがありました。

そのため本検証では、追加検証のような直球質問ではなく、あえて逃げ道のある質問で臨んでみたところです。

それぞれの対話型AIにはまだまだ課題はありますが、

正しい内容で問いかければ、ある程度正しい回答を返してくれます。

要は、利用するニンゲン側がAIに寄り添ってあげて、一緒に答えを導き出すのが理想的なのだろうだと感じました。

本ブログが今後、対話型AIを使う人にとって何らかの参考になれば幸いです。

※1

BingAIおよびChatsonicにはChatGPT-4が、PerplexityAIにはChatGPT-3.5が搭載されています。

今回の検証で対象にした理由については、

・ChatGPT公式が無料で提供しているものがGPT-3.5だった

・各社が独自にデータを学習させている

の、2点からChatGPTの会話内容との差異が出てくることを期待したため採用しました。

※2

DeepL翻訳だと、レンガを指す「bricks」が、なぜか「レンコン」に訳されてしまいました。設定上絶対にありえないので、AIがレンガをレンコンと解釈してしまったのでしょうか?

ちなみにレンコンは英語で lotus rootと訳すみたいです。

関連記事

最新記事

お気軽にお問い合わせください